こんにちは、DX攻略部のkanoです。

「データウェアハウスを導入したいけど、どれを使えばいいのかわからない」

「SnowflakeとBigQueryのどちらにするか迷っている」

こういった悩みをお持ちではありませんか?

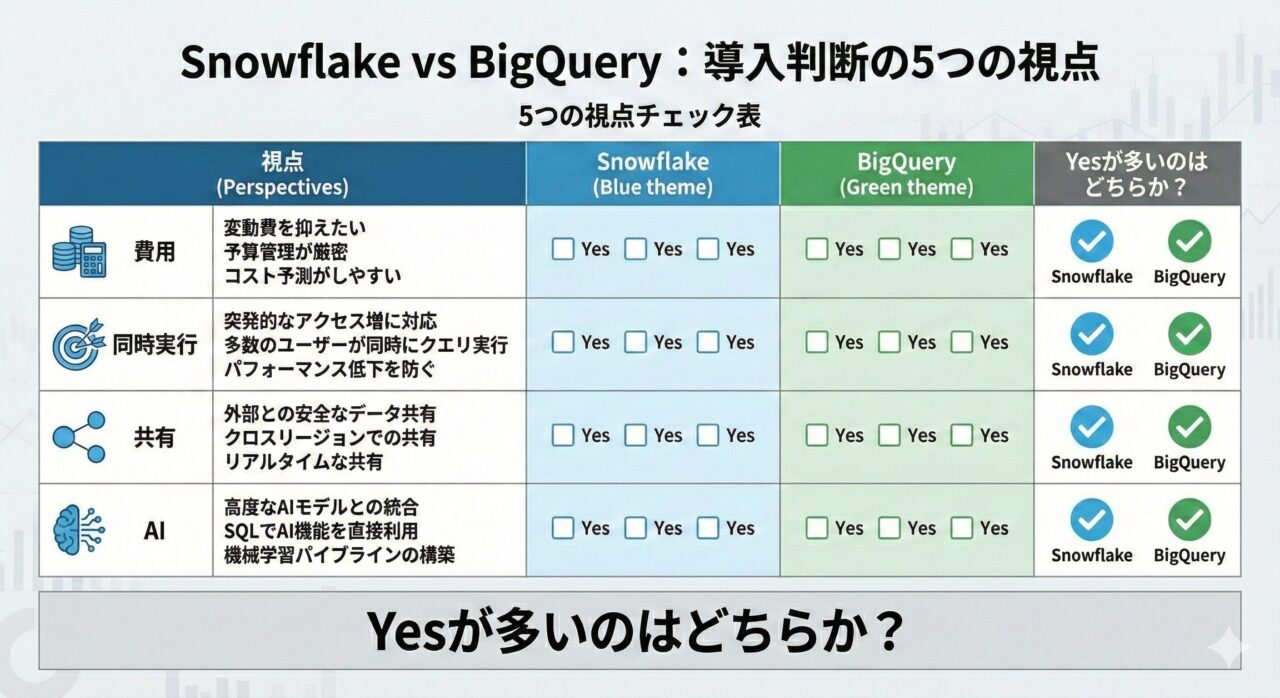

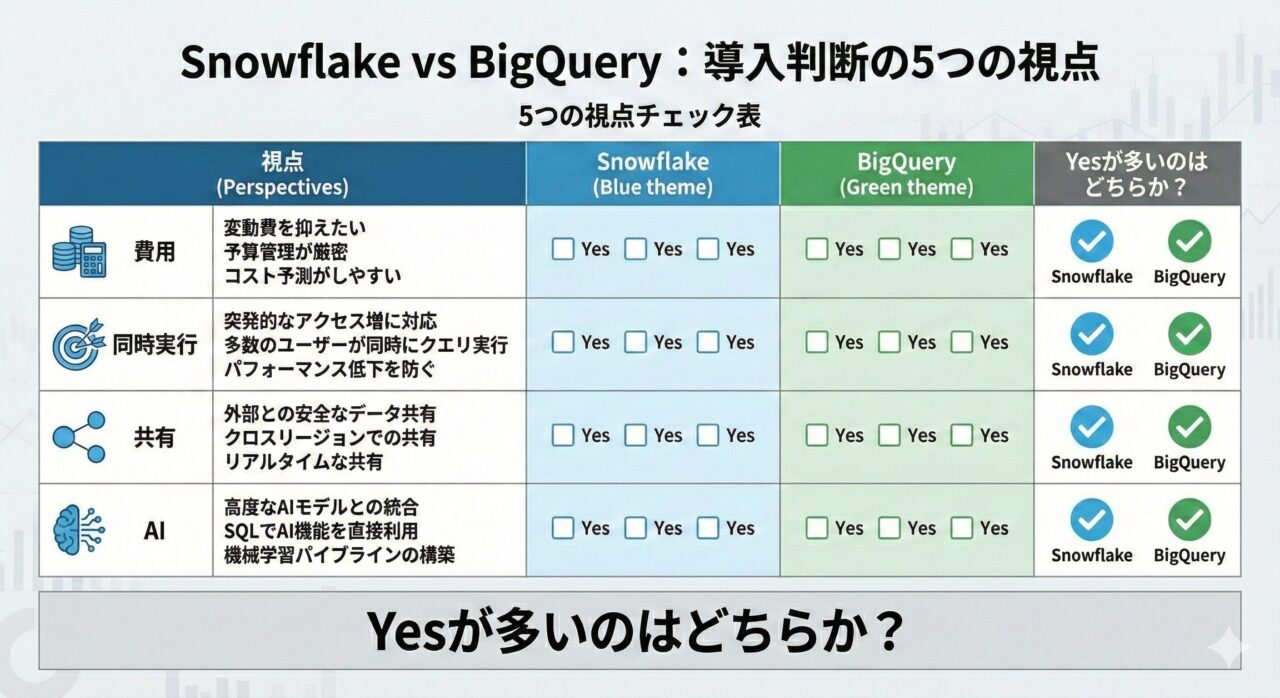

SnowflakeとBigQueryのどちらを導入すべきかは、費用、運用、拡張性、ガバナンス、AI活用という複数の論点が絡みます。

本記事はデータウェアハウス基盤としての機能と運用のしやすさを中心に、幅広い観点からSnowflakeを選ぶ判断材料を整理します。

記事の内容を確認して、Snowflakeを自社に活用してみたいと考えた方は、下記のボタンをクリックしてぜひDX攻略部にご相談ください!

DX攻略部へのお問い合わせ

視点1:費用の総額と月ごとの予測のしやすさ―全社展開の予算ブレを減らせるか

SnowflakeとBigQueryのどちらにするか迷っている場合、費用の総額と月ごとの予測のしやすさを判断基準にしてみましょう。

ここで言う「費用の総額」は、初期費用+毎月の利用料+運用の手間まで含めた合計のことです(一般にはTCOと呼ばれます)。

この「費用の総額」を軸に、SnowflakeとBigQueryの違いを考えていきましょう。

Snowflakeのポイント:上限管理と自動停止でブレを抑える

Snowflakeは計算リソースを用途ごとに分けて動かせるため、チーム単位で上限や自動停止を設定できます。

突発的にクエリが増えても支出が暴走しにくく、「この部門はいくらまで」というガードレール設計が簡単です。

BigQueryのポイント:スキャン量課金と定額予約で読みやすさを調整

BigQueryはクエリで読んだデータ量に応じて支払う方式(オンデマンド)と、あらかじめ処理枠を確保する定額方式(予約)を選べます。

設計や予約の最適化で月額の読みやすさを高められるので、この点がSnowflakeとの違いといえるでしょう。

部門配賦のしやすさ:見える化が社内合意を助ける

どちらの製品でも、利用状況を可視化して部門別に割り当てできます。

Snowflakeはタグと利用状況ビューで、BigQueryはラベルと課金エクスポートで集計する運用が一般的です。

配賦が明確だと「誰がいくら使ったか」が説明しやすくなります。

筆者

配賦(はいふ)とは、複数の部門・部署などにまたがってかかる人件費や光熱費などの間接費用を、一定の基準に沿って割り当てる処理のことです。

ありがちなコスト増の要因と簡単な回避策

長時間のアイドル稼働や不要な高スペック設定はコスト増の原因です。

Snowflakeなら小さめの計算リソースを使い、未使用時は自動停止を徹底しましょう。

BigQueryなら不要な全表スキャンを避け、パーティションやフィルタで読み取り量を絞ることで無駄を抑えられます。

それぞれコスト増となる要因を理解しておけば、回避しやすいので忘れないようにしましょう。

小さく試すときの見るべき数字

ツールを導入する際は、小さく始めることが重要です。

その際に確認したいのは、月の予算内に収まったか、朝のピークでもダッシュボードが何秒で開くか、部門別の利用額は説明できる粒度で見えるか、といった点になります。

この3点を小規模な検証で測ると、自社に合った費用コントロールのしやすさが判断できます。

関連記事

こんにちは、DX攻略部のkanoです。

Snowflakeの料金体系は、料金表を読むだけでは腹落ちしにくいのが正直なところです。

なぜなら費用が「保存(ストレージ)」「計算(コンピュート)」「データ転送」という使い方の結果で決ま[…]

視点2:パフォーマンスとスケール―同時実行に強いのはどちらか

混雑時に待ち時間をどう抑えるかで差が出ます。

SnowflakeとBigQueryのパフォーマンスとスケールについて比較してみましょう。

Snowflakeの考え方(仮想ウェアハウス)

Snowflakeは、用途ごとに計算枠(クエリを動かす力)を分けられます(仮想ウェアハウス=用途別の計算枠)。

部門やシステムごとに別財布を持てるため、混雑とコストの切り分けがしやすくなります。

ピーク時は自動で横に増やし、落ち着けば縮み、他部門の重い処理に引きずられにくいのが利点です。

Snowflakeのウェアハウスについては、以下で詳しく解説していますので、こちらを参考にしてみてください。

関連記事

こんにちは、DX攻略部のkanoです。

「Snowflakeについて調べていると、ウェアハウスという言葉がよく出てくるけど、これってなに?」

「ウェアハウスの仕組みや使う上でのポイントを知りたい」

Snowflakeの「ウ[…]

BigQueryの考え方(スロットとサーバーレス)

全社で処理枠(スロット=計算能力の持ち分)を配り、サーバーレスでクエリを回します。

ダッシュボードは専用の高速化機能を使って体感速度を底上げできるのが特長です。

どちらが向くかの目安

Snowflakeは、部門ごとに独立した計算枠を持たせ、必要な時だけ自動で横に増やして、終わったら止めたい運用に合います。

例えば、マーケは日中S〜Mサイズで即時分析、データ基盤は夜間Lサイズでバッチ処理など、部署・用途別に枠を切り分けたい場合です。

ピーク時の同時実行が多く、他部署の重い処理に引きずられたくない組織、月内に新規プロジェクトが頻繁に増減し、枠を小分けに増やしたり止めたりしたいチームにも合うでしょう。

全社で処理枠をまとめて持ち、使わない時間帯は別部署が使えるよう融通したい場合は、BigQueryが適しています。

例えば、営業ダッシュボードの朝ピークと、ETLの深夜ピークが時間でずれていて、全社最適でひとつの大きな処理能力を配り合う方が効率的な場合です

- 「部署ごとに止める/上限を別管理したい」「他部署の影響を受けたくない」「小さく増減を頻繁にしたい」が多ければSnowflake寄り

- 「全社で処理枠を一元管理したい」「ピークが部署で時間分散している」「既存のGCP集中管理に乗せたい」が多ければBigQuery寄り

視点3:データ共有とエコシステム―社内外コラボを最短にできるか

データコピーや転送はセキュリティとコストの両面でリスクです。

また、「配る速さ・楽さ」が投資回収に直結します。

この点を踏まえながら、SnowflakeとBigQueryの違いを考えていきましょう。

Snowflakeの考え方(コピーしない共有が標準)

Snowflakeは、物理コピーなしで参照権限だけを渡せるという特長があります。

グループ会社やパートナーと安全に素早く共有でき、データの売買や提供も進めやすい設計といえるでしょう。

この特長から、既存のデータレイクも直接扱いたい企業におすすめできます。

BigQueryの考え方(GCPサービス群と一体)

BigQueryは組織間の共有機能に加え、Google Cloud内の各種サービスとつなげて完結できます。

GCP標準で統一運用したい組織では、設計と権限管理をまとめやすい点が利点になります。

筆者

GCP中心のチームには運用がまとまりやすく、データレイクとの統合も得意です。

どちらが向くかの目安

これらの違いを踏まえると、社外・グループ横断の共有を標準動作にしたい場合は、Snowflakeがおすすめです。

GCP内で収集・加工・配布を一気通貫で回したい場合は、BigQueryが適しているといえるでしょう。

関連記事

こんにちは、DX攻略部のkanoです。

「眠っているデータを新しい売上に変えたい」

『眠っているデータを新しい売上に変えたい』と考えた時に重要なのは、売上だけでなく粗利と再現性まで設計することです。

データ収益化は、データ[…]

視点4:ガバナンスとセキュリティ―細粒度の統制をどこまで楽に運用できるか

ツールを導入する際に大切にしたいのが、守ると使うというテーマの両立です。

ガバナンスとセキュリティの観点から、どちらのツールが良いのか検討してみましょう。

Snowflakeの考え方(タグ連携+動的マスキング)

Snowflakeは行・列レベルの制御や動的マスキングを、オブジェクトタグと組み合わせて広く自動適用できます。

そのため、データ分類に応じてポリシーを一貫運用しやすいのが強みです。

BigQueryの考え方(IAM統合+ポリシータグ)

BigQueryは行レベル、列レベルの制御やマスキングを備え、Google CloudのIAMやデータカタログと連携して統制します。

既存のGCP運用に寄せやすい設計が魅力といえるでしょう。

どちらが向くかの目安

それぞれの特長を踏まえると、「分類→自動適用」でルールを広く回したい場合は、Snowflakeが適しています。

既存のGCP権限設計にそのまま乗せたい場合は、BigQueryを使用するほうがスムーズです。

判断に迷ったら、『データ分類のルール変更が月1回以上起きるか』を確認しましょう。

変更が多い組織ほど、タグ連携で自動適用の運用に寄せる方が、統制コストを抑えやすくなります。

関連記事

こんにちは、DX攻略部のkanoです。

新しいツールを導入する際に気になるのが、セキュリティ面の不安です。

Snowflakeは標準機能だけでも、入口(ログイン)と権限、接続元を整えるだけで事故を減らせます。

一方で設定項[…]

視点5:AI/アプリ拡張性―どこでコードを走らせ、どう本番化するか

近年、大きく発展しているのがAI分野です。

SnowflakeもBigQueryもAI活用したデータの取り扱いが可能ですが、データのそばで完結か、外部AI群と連携かの方針差があります。

このAIの取り扱い方の違いから、どのような違いが生まれるか確認していきましょう。

Snowflakeの考え方(SnowparkやUDFで倉庫内完結)

倉庫内完結とは、データを外へ出さずに、分析やアプリ処理までを同じ基盤の中で回す設計です。

経営の観点では、データ移送や権限のつなぎ直しが減るため、ガバナンスを崩さずに本番化の速度を上げやすくなります。

データ移送が減るため、セキュリティやガバナンス(権限や監査の仕組み)を崩さずにスピードを上げやすいのが利点です。

Snowpark(Snowflake上でPython/Java/Scalaなどのコードを動かす仕組み)と、UDF/UDTF(ユーザー定義関数/表関数)を使うと、SQLとコードを組み合わせて柔軟に処理できます。

データ準備(前処理)→特徴量生成→モデル推論→結果の保存→ダッシュボード配信までを、同じ基盤の中で実行できます。

筆者

SQLしか書けない人と、Pythonで分析したい人が同じデータを同じ権限ルールのもとで扱えるため、チーム間の受け渡しコストが小さくなります。

倉庫内完結は、データ移送を最小化したい、部門ごとに安全に試行錯誤したい、SQLとPython/Javaを混ぜて素早く本番化したい、といったニーズに相性が良いです。

BigQueryの考え方(SQLでML+AIサービス連携)

BigQueryは学習・評価・推論の多くをSQLだけで書けるため、データアナリストがそのままMLに踏み込めます。

回帰や分類、時系列予測、レコメンド、クラスタリングなどの主要手法に対応し、モデルは「モデルオブジェクト」として一元管理できるのです。

「SQL中心の一体運用」とガバナンスの一元化を実現したいという目的に適したツールといえます。

どちらが向くかの目安

SnowflakeとBigQueryをAIを活用する観点で比較すると、以下のような判断ができます。

倉庫内で処理を完結し、データ移送を最小化したい場合は、Snowflakeです。

GCPのAIサービスを最大活用したい場合はBigQueryが適しています。

関連記事

こんにちは、DX攻略部のkanoです。

「SnowflakeのSnowparkで何ができるの?」

こういった疑問をお持ちではありませんか?

Snowparkは、Snowflakeの中でPythonなどのコードを動かし、デー[…]

まとめ:Snowflakeで全社データ活用を加速する次の一歩

SnowflakeとBigQueryのどちらを導入するかの、判断材料について紹介しました。

部門ごとに処理リソースを分けたい、予算上限を明確に管理したい、グループ会社や外部パートナーとコピーなしで安全にデータ共有したい、こうしたニーズが強い場合はSnowflakeを第一候補にできます。

既にGCPを標準基盤として使っている、社内のデータ基盤やワークフローがGCP中心で回っている、GCPのAIサービスと密に連携したい、こうした前提があるならBigQueryがスムーズです。

それぞれの得意な部分を理解した上で、SnowflakeとBigQueryのどちらを導入するかを検討しましょう。

そして、DX攻略部では、Snowflake×Streamlitを活用した統合BI基盤構築支援サービスを行っていますので、Snowflake導入を検討している企業様はぜひDX攻略部にご相談ください!

DX攻略部へのお問い合わせ